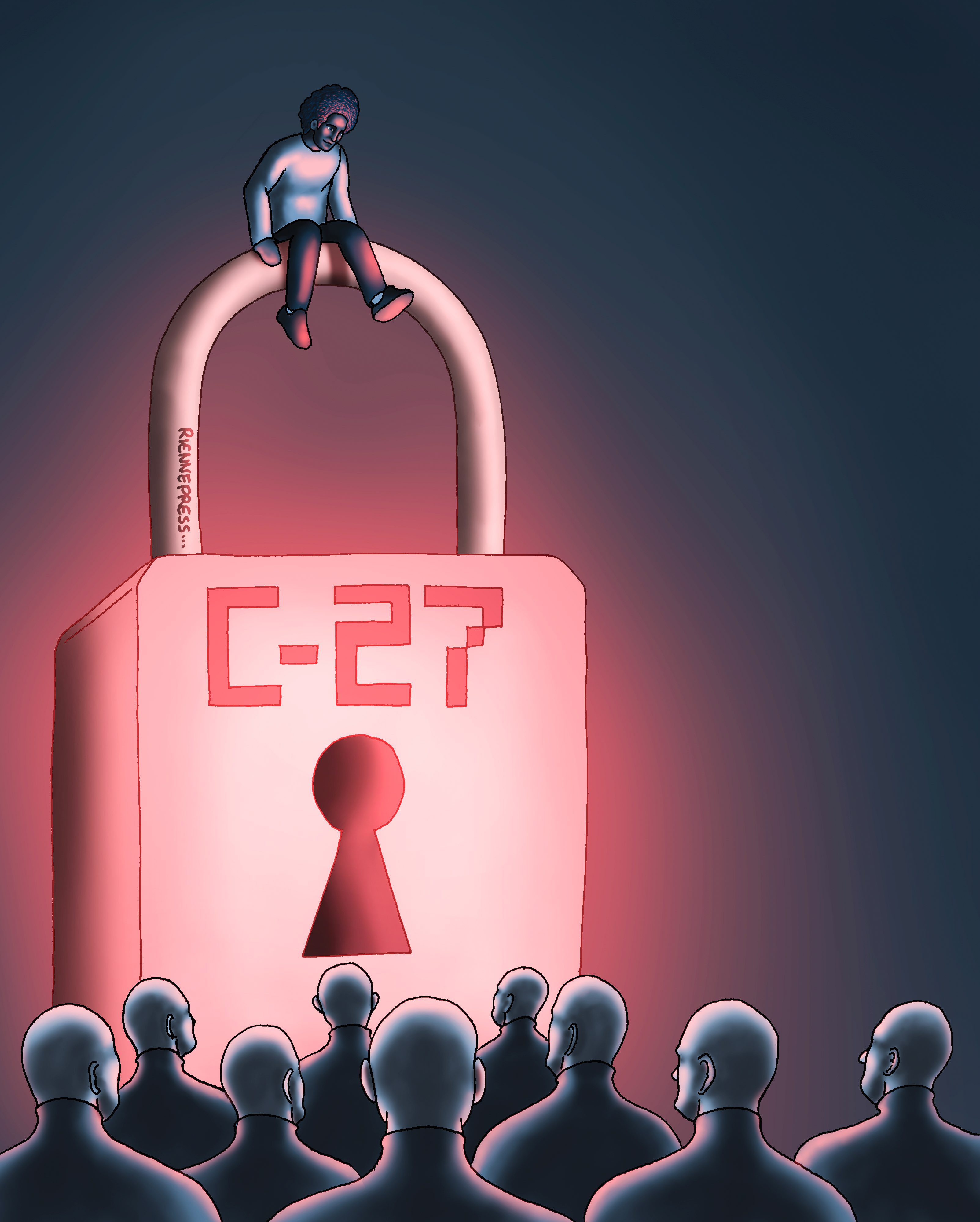

De son côté, le projet de loi canadien à ce sujet a célébré son deuxième anniversaire à la Chambre des communes. Exploration du parcours parlementaire de ce projet de loi et de l’impact qu’il aura sur le paysage des affaires canadien.

Lorsqu’il a été présenté pour la première fois, en juin 2022, le projet de loi C-27 visait à réviser les lois existantes sur la protection de la vie privée et à ajouter une législation indispensable au secteur naissant de l’intelligence artificielle (IA).

Plus de deux ans plus tard, ce projet de loi est-il déjà rendu obsolète en ce qui concerne l’industrie du machine learning?

Quel projet dans quel contexte?

Avant d’entrer dans le vif du sujet, il semble important de mettre du contexte autour de ce projet.

C-27 est la version la plus récente du projet de loi C-11, qui devait remplacer la Loi sur la protection des renseignements personnels et les documents électroniques. Cependant, le projet C-11 a été abandonné après la dissolution du Parlement avec le déclenchement des élections fédérales générales de 2021.

Quelques mois après la victoire minoritaire des libéraux, le projet de loi C-27 est présenté, en juin 2022, en première lecture au Parlement.

Ce projet de loi se divise en trois parties : la Loi sur la protection de la vie privée des consommateurs, qui vise à remettre à neuf les lois existantes sur les renseignements personnels ; la Loi sur le Tribunal de la protection des renseignements personnels et des données, qui vise à établir « un tribunal administratif pour entendre les appels interjetés à l’encontre de certaines décisions rendues par le Commissaire à la protection de la vie privée » ; et la Loi sur l’intelligence artificielle et les données (LIAD), ou la première tentative du Canada de réglementer l’IA (1) .

Une première tentative

Lors de sa première lecture, la partie de ce projet de loi relative à l’IA laissait beaucoup à désirer. Elle comportait une définition imprécise d’un système d’IA, une explication vague d’un « système à incidence élevée » et introduisait l’idée « d’effectuer une vérification au sujet des personnes responsables du développement et de la mise à disposition de systèmes d’IA en cas de contravention soupçonnée ».

Benjamin Faveri, chercheur en gouvernance, droit et politique de l’IA à l’Arizona State University, pointe notamment la faille sur les vérifications. « J’ai trouvé qu’il manquait de spécificité en ce qui concerne les exigences quant à ces vérifications.

« Ce qui est censé être inclus dans ces vérifications n’est pas très clair. Qu’est-ce qui est contrôlé exactement? S’il est effectué par un tiers ou un auditeur indépendant, qui nommera cette personne? Peut-il s’agir de n’importe quel cabinet d’audit?

« C’est une bonne chose qu’il y ait une formulation à cet effet. Mais rien ne dit qu’un cabinet d’audit compétent ou un cabinet d’audit tiers accrédité devrait être chargé de ces vérifications. »

Cette précision devrait se faire dans des règlements à venir pour décider des qualifications dont l’auditeur aurait besoin.

« La LIAD a tenté de résoudre ce problème en disant qu’elle développerait cette question ou proposerait un langage plus détaillé dans les règlements à venir. Mais ces derniers n’ont pas encore été publiés. »

Un autre aspect

Un autre aspect souvent critiqué de ce projet de loi concerne la définition d’« un système à incidence élevée ». Bien que la définition renvoie également à des règlements à venir pour définir correctement ce terme, plusieurs sections de ce projet de loi ne s’appliquent qu’aux systèmes d’IA considérés comme tels.

« Les gens ont tendance à penser toutes les IA comme étant à haut risque ou à incidence élevée. Il est vrai que différents systèmes d’IA opèrent dans différentes industries et comportent donc des risques plus importants. Mais pas tous.

« Au Canada, le gouvernement fédéral dispose de ce qu’on appelle : l’évaluation de l’incidence algorithmique. Je pense que c’est cette évaluation qui permettra à la LIAD de déterminer si un système d’IA présente un risque élevé ou faible.

« Par exemple, le logiciel Grammarly (qui permet de vérifier la syntaxe d’un texte en anglais) est un système d’IA à faible risque. Il n’a pas d’impact direct sur qui que ce soit. Le logiciel se contente de faire des recommandations sur la grammaire, le choix des mots ou d’autres éléments dans un document Word ou PDF.

« En revanche, les banques qui prennent des décisions de prêt sur la base du comportement d’une personne en matière de dépenses ou de crédit ont un impact plus important sur la vie de cette personne, qu’elle soit approuvée ou non. On comprend donc bien la différence entre une IA à risque élevé ou à risque faible. »

Des amendements

Le ministre de l’Innovation, des Sciences et de l’Industrie François-Philippe Champagne, a abordé certaines questions de clarté à l’automne 2023 dans une lettre dans laquelle il a dressé une liste de modifications proposées à la LIAD (2).

« Il est essentiel que nous adoptions la LIAD maintenant », a déclaré François- Philippe Champagne dans sa lettre. « Nous sommes à un tournant de l’histoire de l’IA, tant au Canada qu’à l’échelle mondiale, et les coûts d’un retard pour les Canadiens seraient considérables. »

Le premier amendement proposé apporte une clarification très attendue sur les « systèmes à incidence élevée », créant sept catégories de systèmes dans lesquels l’utilisation de l’IA est susceptible de causer des dommages élevés : l’utilisation dans l’emploi ou le recrutement, la détermination de la prestation de services ou la fixation de prix, l’utilisation de l’IA pour traiter des informations biométriques, la modération de contenu, l’utilisation de l’IA dans les soins de santé, l’utilisation de l’IA dans les tribunaux et l’utilisation de l’IA par un agent de la paix.

Définitions plus précises

Les autres amendements comprenaient des définitions plus précises des systèmes d’IA et du machine learning, s’alignant davantage aux définitions de l’OCDE et de l’Union européenne, l’ajout de normes pour les systèmes à incidence moyenne ou faible et l’exigence de cadres de responsabilité pour les organismes impliqués dans l’IA. Un autre amendement a été sur l’ajout d’exigences différentes pour chaque acteur qui rend un système d’IA accessible au public.

D’après Benjamin Faveri, ces amendements constituent déjà un premier pas positif. « Je pense que leur façon d’aborder [la question des dommages potentiels] était de s’attaquer aux systèmes à incidence élevée.

« On peut soutenir que les systèmes à incidence élevée sont susceptibles de causer davantage de dommages. De fait, en augmentant la charge liée à l’utilisation ou au fonctionnement des systèmes d’IA à haut risque, on atténue les dommages potentiels. »

Quatre difficultés

Malgré ces amendements, Benjamin Faveri souligne que l’élaboration de législations en matière d’IA se heurte à quatre difficultés majeures. « La première est que plusieurs industries complètement dif-férentes utilisent l’IA ce qui requière différentes règles. Comme expliqué plus tôt, la LIAD adopte une approche générale, en classant les systèmes d’IA selon leur incidence élevée ou faible.

« Mais sur la question de la réglementation, des normes ou des meilleures pratiques de l’industrie, il est important d’adopter une approche sectorielle. Il est difficile d’y parvenir car il faut l’expérience et le savoir des experts dans chacune de ces industries. »

Une deuxième difficulté est celui de la fragmentation : le fait que plusieurs lois parfois contradictoires soient en cours de rédaction rend difficile pour les nouvelles entreprises de déterminer les règles qu’elles doivent suivre.

« Une troisième difficulté est celui de la juridiction. Au Canada, nous avons plusieurs niveaux de gouvernements : fédéral, territorial, provincial, municipal et les gouvernements autochtones.

« Lorsque des entreprises opèrent dans plus d’une juridiction ou tout simplement avec d’autres pays, il devient complexe de s’assurer qu’elles respectent les règles dans chacune des juridictions.

« Ce point nous amène à la quatrième difficulté : celui de l’applicabilité. Il est très difficile d’appliquer certaines règles qui ne seront en place que dans une seule juridiction. Les règles établies au niveau fédéral au Canada ne s’appliquent pas aux États-Unis ni à l’Union européenne. Il est difficile de s’assurer que les entreprises se comportent bien lorsqu’elles opèrent à l’échelle internationale. »

Évolution rapide

Le domaine de l’IA étant très récent et évoluant rapidement, les décideurs politiques ne savent toujours pas comment aborder de manière appropriée les questions relatives à ce domaine.

Cependant, l’idée que plusieurs aspects des lois sur l’IA pourront être ajoutés sous forme de réglementations à venir donne espoir à des experts que le gouvernement fédéral souhaite garder une marge de manoeuvre et d’adaptabilité face aux avancées technologiques et aux nouvelles législations internationales (3).

C’est le cas de Benjamin Faveri. « Il faut faire confiance au processus législatif, il y a encore de la place pour des modifications. Bien sûr, ce projet de loi pourrait être meilleur. Mais la réglementation de l’IA est quelque chose que beaucoup de gens demandent et nous obtenons ce que nous avons demandé. »

Le projet de loi C-27 et les entreprises canadiennes

Bien que cette législation repose en grande partie sur des règlements à venir, les entreprises canadiennes peu-vent s’y préparer de quelques manières. Selon le document complémentaire à la LIAD, qui est fréquemment mis à jour. « Il n’y a pas de responsabilités claires au Canada quant à ce que les entreprises devraient faire pour s’assurer que les systèmes d’IA à incidence élevée sont sûrs et non discriminatoires » (4). Une déclaration qui accorde beaucoup de responsabilité aux développeurs de systèmes d’IA, qui devront tenir des registres rigoureux sur la manière dont ils ont entraîné leurs systèmes et sur ce qu’ils ont fait pour éviter la discrimination et d’autres formes de préjudices personnels.

Jusqu’à présent, les entreprises qui conçoivent, développent et mettent à disposition des systèmes à fort impact ont la plus grande responsabilité et la plus grande capacité d’adaptation, car on peut s’attendre à ce qu’elles démontrent qu’elles ont pris les mesures nécessaires lors de la conception et du déploiement de leurs outils afin de limiter les dommages et de comprendre les limites de leurs systèmes d’IA. Par ailleurs, les entreprises qui « gèrent les opérations d’un système d’IA » devront exercer une surveillance constante de ce système pour confirmer que les risques et les limites sont gérables.

Informations personnelles

Cela dit, le document mentionne aussi l’utilisation de systèmes d’IA en libre accès ou open source : en soi, ils ne peuvent pas être considérés comme des systèmes d’IA complets, mais la loi s’appliquerait aux entreprises « rendant disponible un système d’IA à incidence élevée pleinement fonctionnel, y compris s’il était rendu disponible en libre accès. » En d’autres termes, une entreprise qui utilise le code ou la licence en libre accès d’un système d’IA, puis y ajoute ses propres données pour entraîner le système à être utilisé dans l’une des catégories à haut risque, serait également soumise aux règlements destinés à prévenir les dommages causés aux individus.

Bien que la responsabilité d’atténuer les risques de discrimination et de préjudice pour les individus incombe principalement aux entreprises qui gèrent les systèmes d’IA plutôt qu’à ceux qui les utilisent, la LIAD n’est qu’un tiers d’un ensemble législatif plus vaste visant à réviser les lois existantes en matière de protection de la vie privée. Les nouvelles lois concernant les informations personnelles seront elles aussi plus strictes et pourraient donc entraîner des changements même pour les entreprises qui n’ont pas l’intention de créer leurs propres outils d’IA.

(1) https://www.parl.ca/documentviewer/fr/44-1/projet-loi/C-27/premiere-lecture

À lire aussi : D’abord, qu’est-ce que c’est l’IA? (dossier spécial 1/4)

À lire aussi : IA : le nouveau meilleur ami de l’entrepreneur? (dossier spécial 2/4)

À lire aussi : IA : la fin de l’ère de l’emploi? (dossier spécial 3/4)